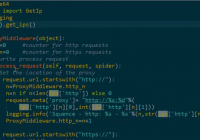

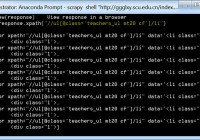

一、start_requests方法

start_requests方法是启动爬虫时自动调用的方法,我们可以对其进改改写,比如让它变成post请求,并改变它的回调函数。

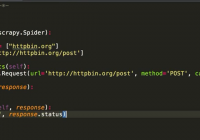

二、make_requests_from_url(url)

我们可以通过重写make_requests_from_url(url),改变它的回调函数。

scrapy源码:

一、start_requests方法

start_requests方法是启动爬虫时自动调用的方法,我们可以对其进改改写,比如让它变成post请求,并改变它的回调函数。

二、make_requests_from_url(url)

我们可以通过重写make_requests_from_url(url),改变它的回调函数。

scrapy源码:

Scrpy使用代理IP及分布式

Scrpy的第八个爬虫慕课网(下载图片)

0

Requests与Xpath搭配(教程)

0

Scrpy的第七个爬虫Travelcity(调试及异步写入SQLite)

0

《Python网络爬虫实战》笔记(Xpath)

0

fiddler教程(fiddler可以用来做什么)

0

Scrpy的第六个爬虫(爬取腾讯招聘)

0

采集安居客

0

Scrpy的第五个爬虫(爬取详细页面写入SQLite)

0